패스트캠퍼스 환급 챌린지

패스트캠퍼스 환급챌린지 3일차 미션(2월3일):프롬프트 엔지니어링으로 시작하는 AI/LLM 서비스 개발 강의후기

foruheon

2025. 2. 3. 23:25

본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성하였습니다.

Prompt Engineering 파트 실습 3 - 1. 평가 기준 설정

평가 지표는 단순한 숫자가 아니다

강의에서는 대표적인 LLM 평가 지표(예: MMLU, ARC, HellaSwag, TruthfulQA 등)를 소개했다. 하지만 중요한 점은, 이 지표들이 절대적인 기준이 아니라 태스크에 따라 유의미한 차이를 보일 수 있다는 것이다.

예를 들어, Mistral이 LLaMA2보다 더 높은 점수를 기록했지만, 특정 한글 Q&A 태스크에서는 반대의 결과가 나왔다. 즉, 모델 선택 시에는 전반적인 성능이 아니라, 실제 활용할 태스크와 평가 지표 간의 연결성을 고려해야 한다는 점을 깨달았다.

단순한 정확도(Accuracy) 평가를 넘어, 의미를 고려한 평가가 필요하다

- 객관식 문제처럼 정답이 명확한 경우, Accuracy 같은 평가 지표를 활용하는 것이 효과적이다.

- 하지만, 요약이나 생성형 태스크에서는 단순히 "정답과 얼마나 유사한가?"보다는 의미적으로 더 나은 평가 기준이 필요하다.

- Cosine Similarity나 Recall 기반의 평가도 있지만, 정답 자체가 완벽하지 않을 수 있기 때문에 LLM을 활용한 평가 방식이 필요하다는 점이 흥미로웠다.

사람이 평가하는 방식과 LLM이 평가하는 방식의 차이

- 사람 기반 평가 (Human-Based Evaluation)

- 전문가 블라인드 A/B 테스트 → ELO 리더보드 방식

- LMSys Chatbot Arena처럼 사용자가 직접 모델의 답변을 비교하며 평가하는 시스템 활용

- 다만, 사람이 평가하는 데 시간이 많이 걸리고, 객관성을 유지하기 어렵다는 단점

- 모델 기반 평가 (Model-Based Evaluation)

- GPT-4 같은 강력한 LLM을 "심판"으로 사용하여 평가

- 사람이 평가한 것과 유사한 결과를 도출할 수 있음

- 특히, MT-Bench 논문에서 소개한 3가지 평가 방식이 인상적이었다:

- Pairwise Comparison (둘 중 더 나은 답변 선택)

- Single Answer Grading (단일 답변 점수 매기기)

- Reference-Guided Grading (정답 예시를 기준으로 평가)

사람이 평가할 때는 직관적이지만 시간이 많이 걸리고, LLM이 평가하면 효율적이지만 평가의 신뢰성을 검증해야 한다는 점이 차이점이었다.

① 오늘자 날짜, 공부 시작 시각

② 오늘자 날짜, 공부 종료 시각

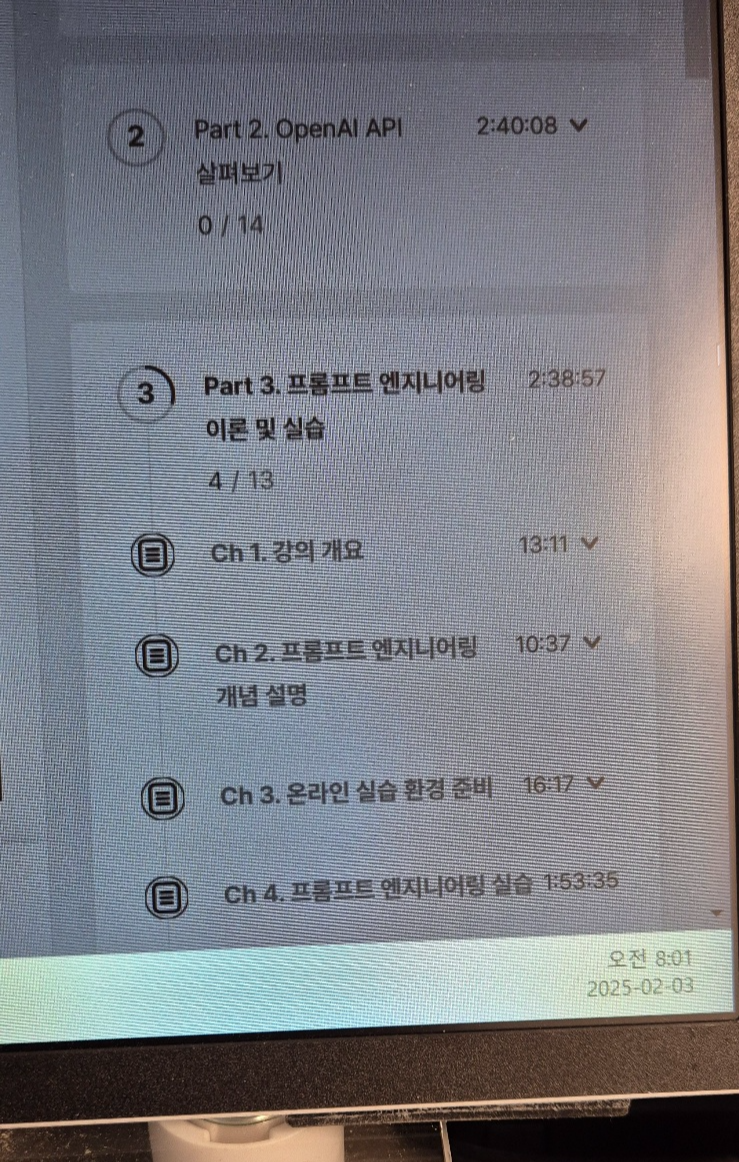

③ 클립 1번 수강 인증 사진

④ 클립 2번 수강 인증 사진

⑤ 학습 인증샷 1장 이상 (ex. 필기 촬영, 작업물, 등)

빌링 오류가 나서 안된다....